MagicAnimate

基于扩散模型的人类图像动画框架

不仅支持把静止的图片变成动作视频。

还能结合文本成动画,而且还支持多人照片。

MagicAnimate 是一个基于扩散模型的人类图像动画框架,旨在增强时间一致性、忠实保留参考图像,并提高动画的真实感。

主要功能特点

1、时间一致性动画:MagicAnimate 的目标是根据运动序列使参考图像动起来,并保持时间上的一致性。能够确保动画在时间上的连贯性,动画中的动作看起来自然流畅,没有突兀的变化。

2、忠实于原图:在动画化过程中,它能够保持对原始参考图像的高度忠实度,确保动画中的人物或对象与原图保持一致。

3、跨身份动画:MagicAnimate 还能够进行跨身份动画,即使用来自不同视频的运动序列来动画化参考图像。网站展示了三个身份和两个运动序列的视频结果。

4、未见领域动画:该项目能够动画化未见领域的图像,例如油画和电影角色,使其执行跑步或瑜伽等动作。

5、与T2I扩散模型结合:MagicAnimate 还可以与DALLE3生成的参考图像结合,使其执行各种动作。每个参考图像的文本提示也在视频下方展示。

6、多人动画:该框架还支持多人动画,根据给定的运动序列动画化多个人物。

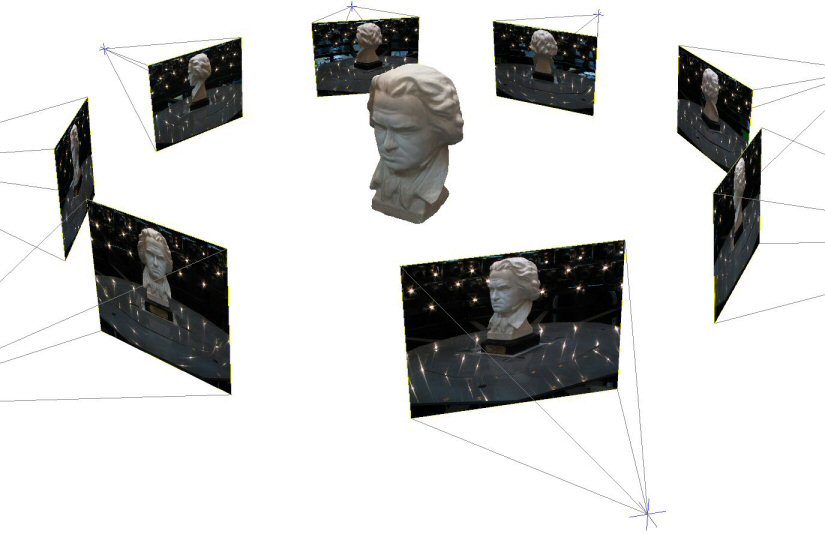

MagicAnimate 使用视频扩散模型和外观编码器来进行时间建模和身份保持。为了支持长视频动画,开发了一个简单的视频融合策略,在推理过程中产生平滑的视频过渡。

主要工作原理

1、视频扩散模型:MagicAnimate 使用一种称为视频扩散模型的技术。这种模型能够处理时间序列数据,即它不仅考虑单个图像,还考虑图像随时间的变化。这使得生成的动画在时间上保持连贯和一致。

2、外观编码器:为了保持动画中人物的身份和外观特征与原始图像一致,MagicAnimate 使用外观编码器。这个编码器确保即使在动画过程中,人物的基本特征(如面部特征、服装等)保持不变。

3、参考图像和目标动作序列:在生成动画时,MagicAnimate 需要两个输入:一是参考图像(如人物照片),二是目标动作序列(描述人物应该如何移动)。这些动作序列可以是预先定义的,也可以是根据特定任务动态生成的。

4、视频融合策略:为了支持长视频动画的生成,MagicAnimate 采用了视频融合策略。这种策略能够在动画的不同部分之间平滑过渡,避免突兀的切换,从而生成更自然的长时动画。

5、多样化应用:除了基本的图像动画化,MagicAnimate 还能应用于更多场景,如将未见领域的图像(例如油画或电影角色)动画化,或者结合文本描述生成动画。

这种技术在动画制作、游戏设计、虚拟现实等领域具有广泛的应用潜力。

项目及演示: https://showlab.github.io/magicanimate/

论文: https://arxiv.org/abs/2311.16498

GitHub: https://github.com/magic-research/magic-animate

Huggingface在线测试: https://huggingface.co/spaces/zcxu-eric/magicanimate